这里或许是互联网从业者的最后一片净土,随客社区期待您的加入!

您需要 登录 才可以下载或查看,没有账号?立即注册

×

本帖最后由 as22 于 2025-6-6 14:58 编辑

6月6日消息,今日,通义千问宣布正式发布Qwen3-Embedding系列模型, Qwen模型家族的新成员。

据介绍,该系列模型专为文本表征、检索与排序任务设计,基于Qwen3基础模型进行训练,充分继承了Qwen3在多语言文本理解能力方面的优势。

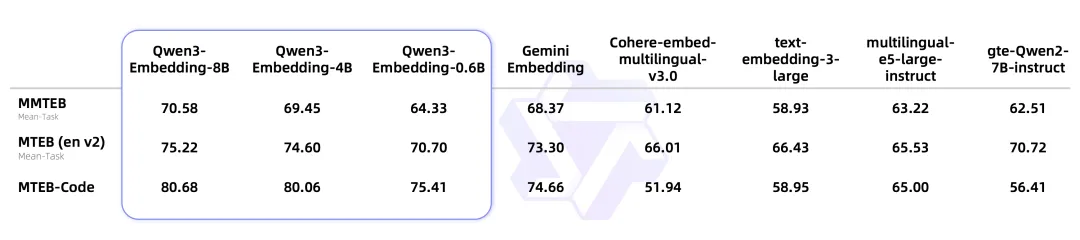

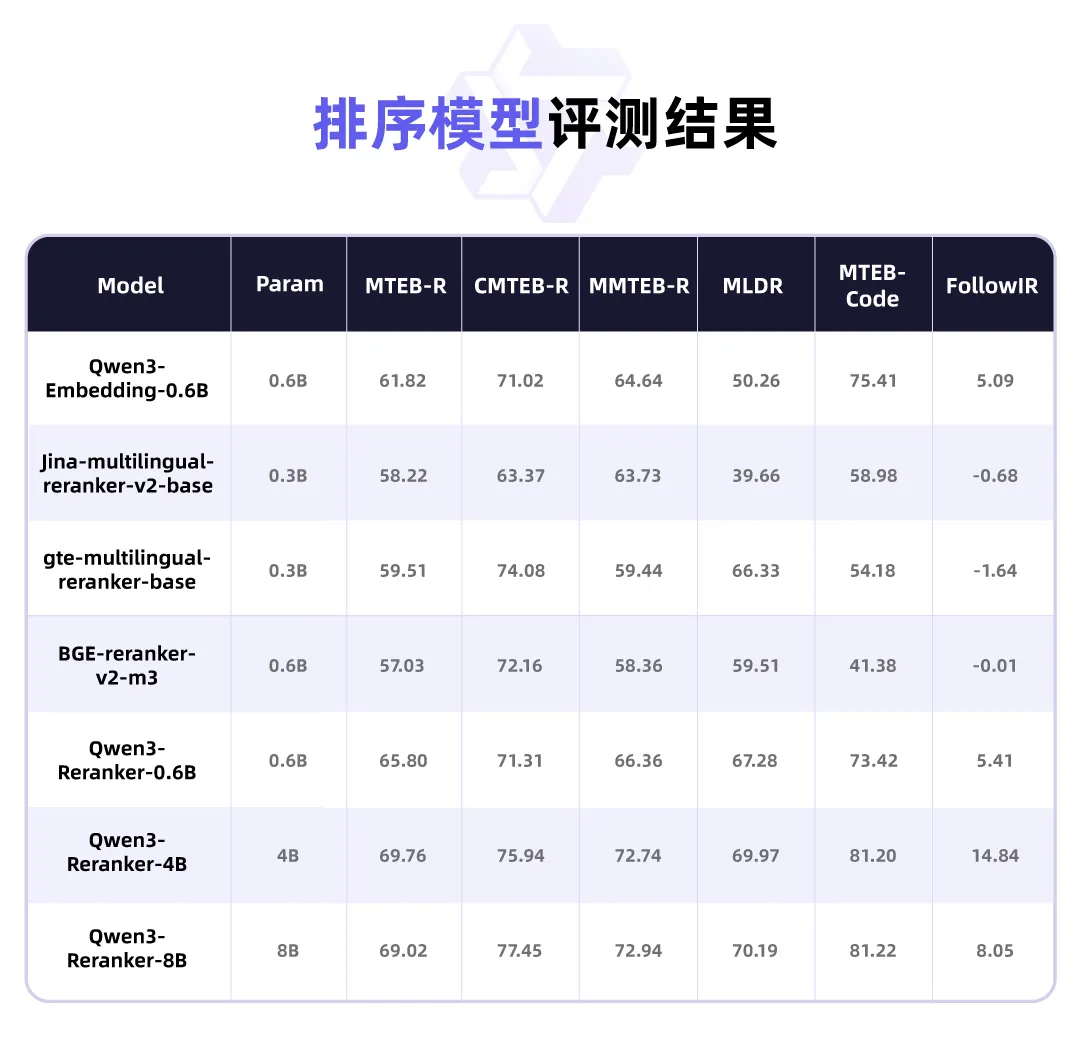

在多项基准测试中,Qwen3-Embedding系列在文本表征和排序任务中展现了卓越的性能。

该系列模型主要有以下特点:

卓越的泛化性:Qwen3-Embedding系列在多个下游任务评估中达到行业领先水平。其中,8B参数规模的Embedding模型在MTEB多语言Leaderboard榜单中位列第一(截至2025年6月6日,得分70.58),性能超越众多商业API服务。此外,该系列的排序模型在各类文本检索场景中表现出色,显著提升了搜索结果的相关性。

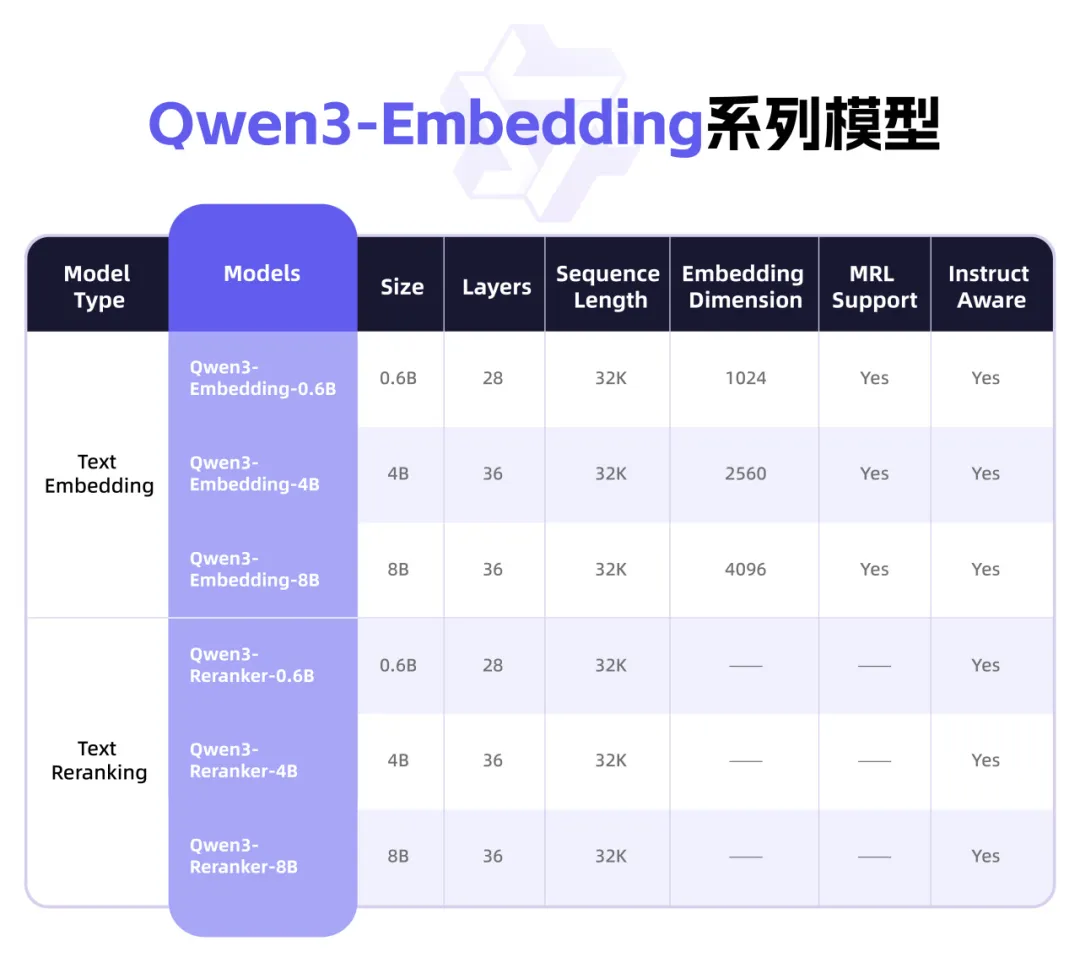

灵活的模型架构:Qwen3-Embedding系列提供从0.6B到8B参数规模的3种模型配置,以满足不同场景下的性能与效率需求。开发者可以灵活组合表征与排序模块,实现功能扩展。

此外,模型支持以下定制化特性:

1) 表征维度自定义:允许用户根据实际需求调整表征维度,有效降低应用成本;

2) 指令适配优化:支持用户自定义指令模板,以提升特定任务、语言或场景下的性能表现。

全面的多语言支持:Qwen3-Embedding系列支持超过100种语言,涵盖主流自然语言及多种编程语言。该系列模型具备强大的多语言、跨语言及代码检索能力,能够有效应对多语言场景下的数据处理需求。

据悉,基于Qwen3基础模型,Embedding模型和Reranker模型分别采用了双塔结构和单塔结构的设计。通过LoRA微调,最大限度地保留并继承了基础模型的文本理解能力。

Embedding模型接收单段文本作为输入,取模型最后一层「EOS」标记对应的隐藏状态向量,作为输入文本的语义表示; Reranker模型则接收文本对(例如用户查询与候选文档)作为输入,利用单塔结构计算并输出两个文本的相关性得分。

在训练过程中,Qwen3-Embedding系列采用了多阶段训练范式,针对具体应用场景进行了深度优化。Embedding模型采用三阶段训练架构,包括超大规模弱监督数据进行对比学习预训练、基于高质量标注数据进行的监督训练,以及模型融合策略。而Reranker模型则直接采用高质量标注数据进行监督训练,以提升训练效率。

目前,该系列模型已在Hugging Face、ModelScope和GitHub平台开源,用户也可以直接使用阿里云百炼平台提供的最新的文本向量模型服务。 |